Find sensitive files

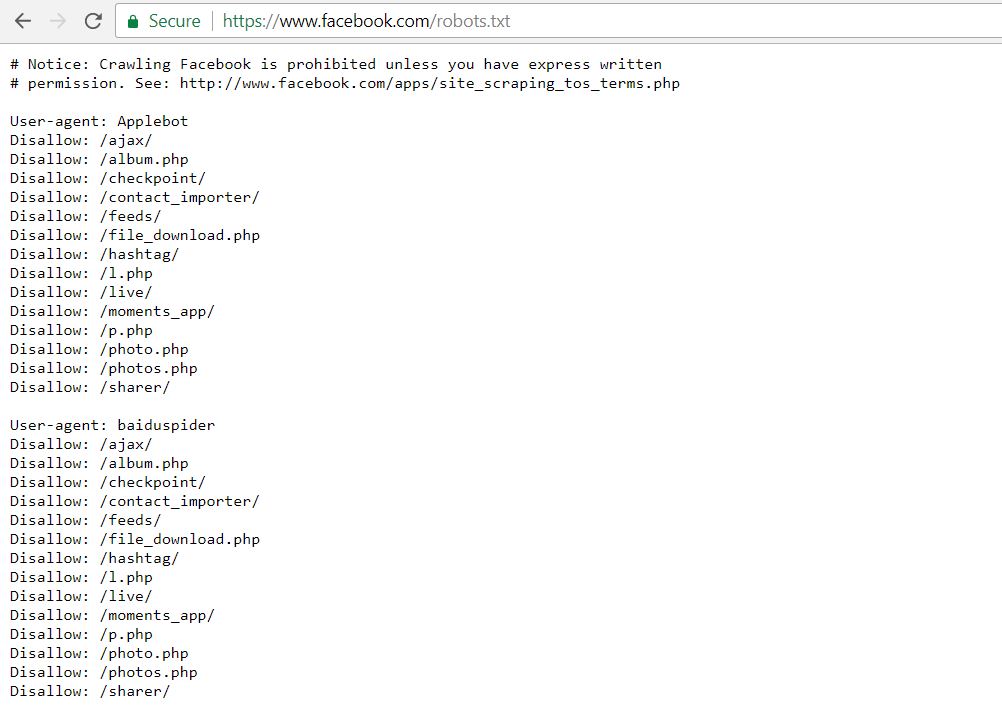

Dữ liệu nhạy cảm ở đây chính là tập tin robots.txt của các ứng dụng web. Có thể với người dùng bình thường, sự tồn tại của tập tin này không hề được biết đến. Nhưng với các nhà phát triển web kĩ tính và có cái nhìn nghiêm túc về bảo mật, cũng như những người chuyên về SEO, các nhà quảng cáo thì tập tin này rất quan trọng.

Nó chứa những thông tin về các URL cần được loại bỏ khỏi các web crawler trên Internet, từ đó giúp các trang nhạy cảm không phơi bày ra trong các kết quả tìm kiếm của các search engine trên mạng.

Tập tin này thông thường có thể truy cập và tìm thấy ở dạng như sau:

https://example.com/robots.txt

Lấy một ví dụ, ta thử nghiệm với trang Facebook.com và xem kết quả trả về.

Như bạn thấy, có rất nhiều liên kết bị disallow trong tập tin này. Danh sách đầy đủ có thể xem tại:

https://www.facebook.com/robots.txt

Với những thông tin trong robots.txt, kẻ tấn công có thể rút ngắn thời gian thực hiện quá trình thăm dò và khảo sát mục tiêu, vì tất cả những thông tin cần tìm đã được chủ nhân của nó ghi nhận lại trong đây cả.

Read the content of sensitive files

Với những tập tin tìm được, làm sao có thể đọc được nội dung của chúng? Với những tập tin được giấu đi trong robots.txt, nếu là định dạng PHP thì không có cách để đọc được, vì nó do PHP Handler xử lý, nên ta không thể xem được.

Nhưng với những định dạng như .config, thì khả năng xem trực tiếp được ngay trên trình duyệt là cực kỳ cao.

Demo: sensitive configuration file

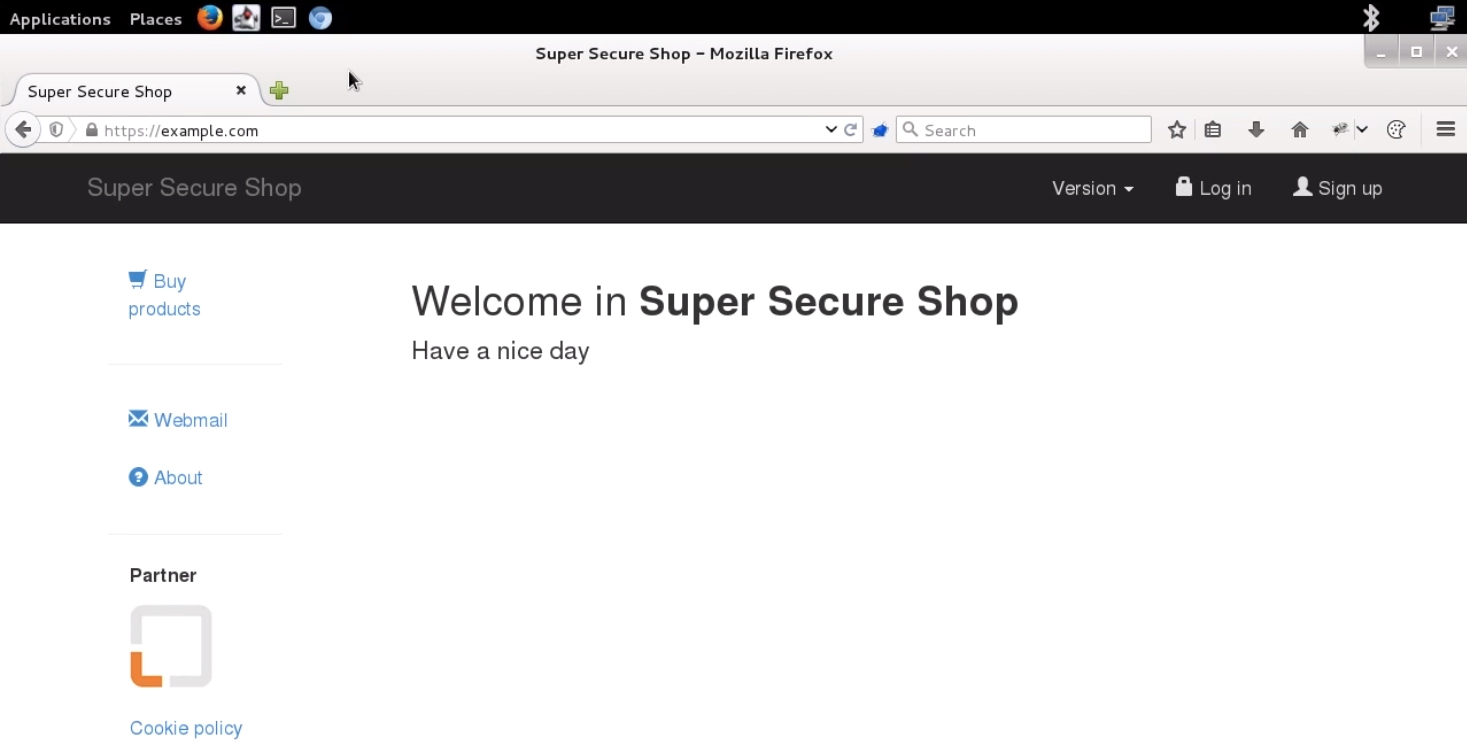

Ta có một trang web bán hàng online như sau.

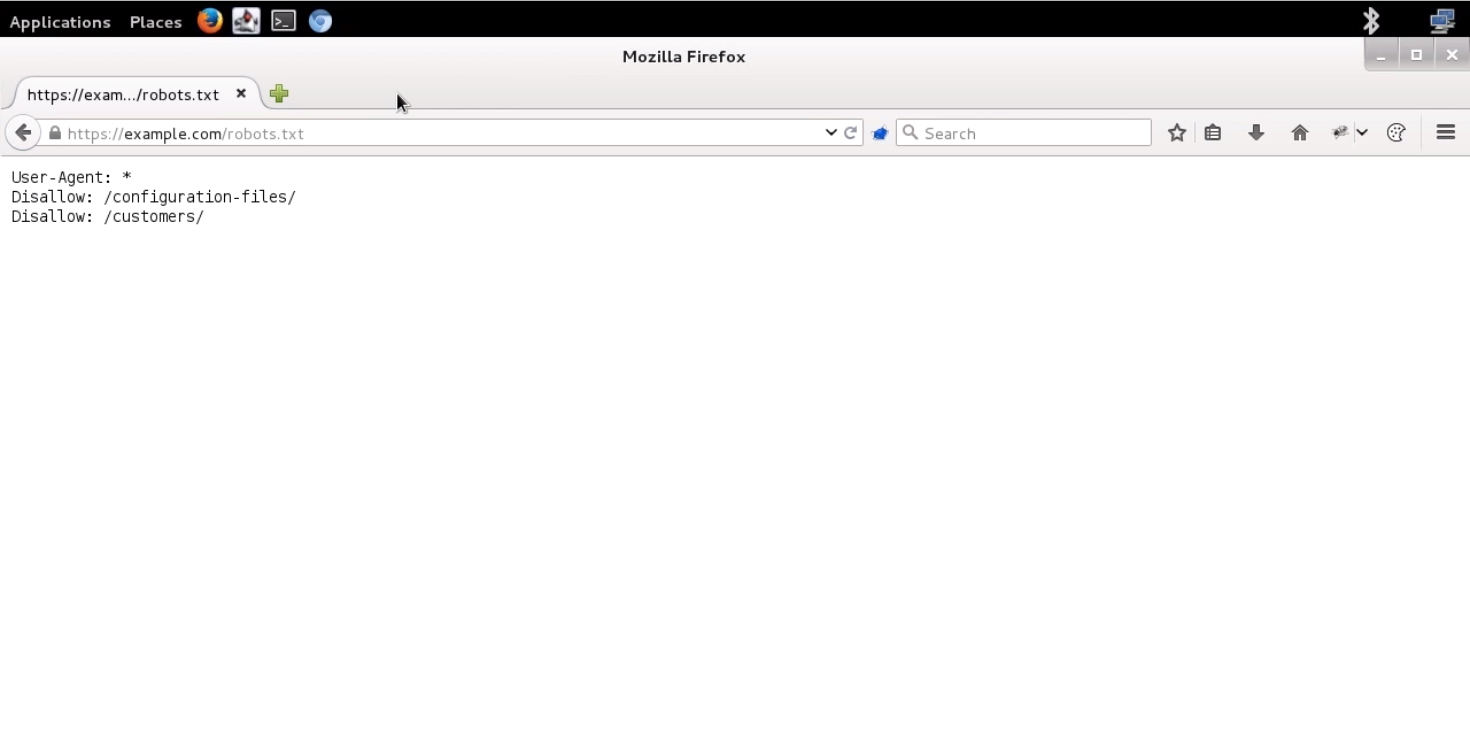

Sau khi dạo một vòng, ta thử truy cập robots.txt của nó, xem thử nhà phát triển đã giấu đi những đường dẫn nào khỏi tai mắt của các web crawlers.

Ta thấy, có hai tập tin được ẩn đi.

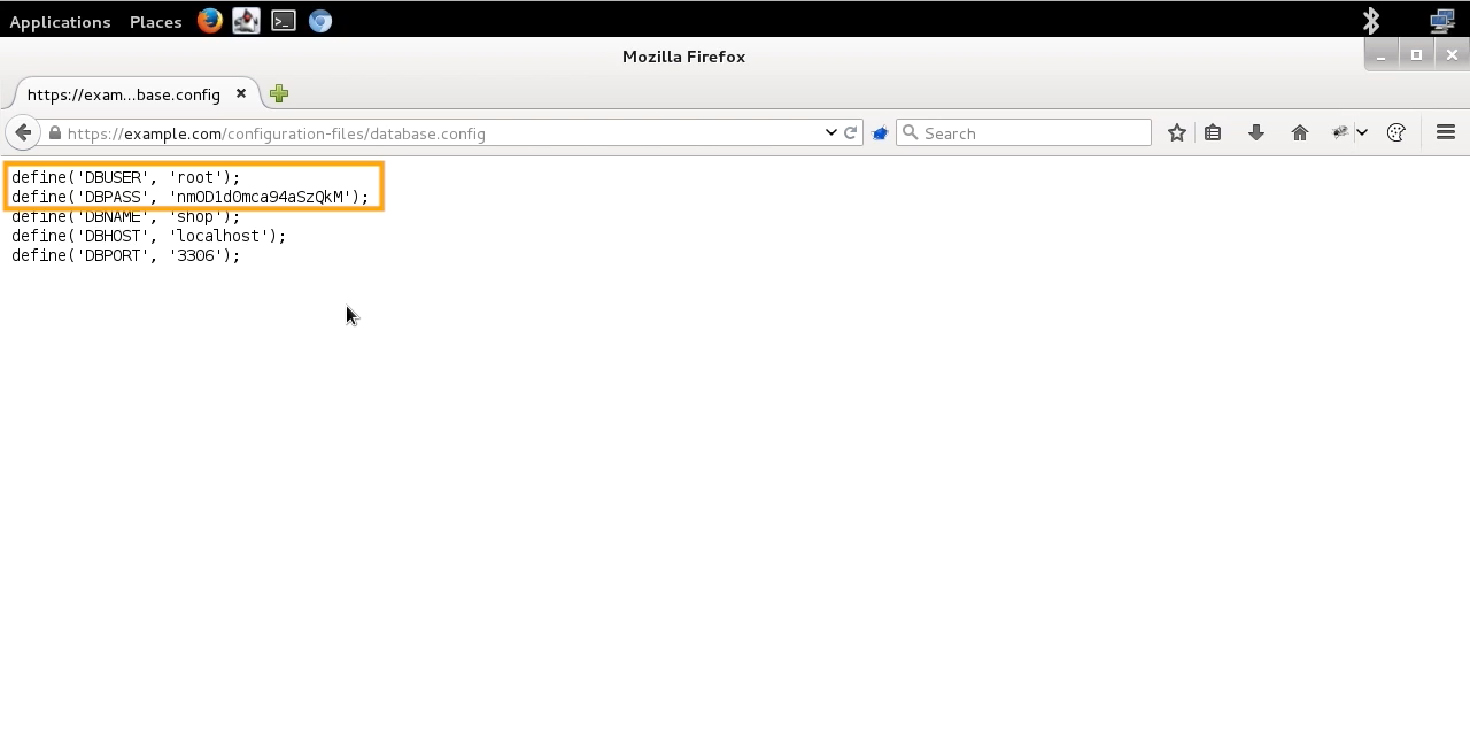

Quan sát, tập tin có định dạng .php sẽ được xử lý bởi PHP handler, nên không có cách nào để đọc source của nó cả. Nhưng với tập tin .config, thì ta thử nhấp vào.

Như bạn có thể thấy, tập tin này được xử lý nhanh gọn bằng trình duyệt khi ta đưa ra yêu cầu truy cập.

Đây chính là thông tin về user và database của ứng dụng web này đang sử dụng.

Summary

Với việc khai thác tập tin robots.txt, kẻ tấn công có thể lấy được kha khá thông tin hữu ích từ mục tiêu. Bởi đặc trưng là ẩn đi các đường link nhạy cảm khỏi các web crawlers, nên việc tìm kiếm trong đây sẽ dẫn đến những thông tin có nguy cơ cao cho an toàn của hệ thống.

Bởi đặc trưng các định dạng file, tùy theo handler nào mà ta có thể đọc được nội dung các tập tin có trên server hay không.

Có thể bạn quan tâm:

Bài 1: Web App Hacking: Sensitive Data Exposure (Guideline)

Bài 2: Web App Hacking: Sensitive Data Exposure – Insecure Error Handling

Bài 3: Web App Hacking: Sensitive Data Exposure – Disclosure of Sensitive Files

Bài 4: Web App Hacking: Sensitive Data Exposure – Information Disclosure via Metadata

Bài 5: Web App Hacking: Sensitive Data Exposure – Underestimated Risk: Disclosure of Software Version

Bài 6: Web App Hacking: Sensitive Data Exposure – Insecure Communication Channel

Bài 7: Web App Hacking: Sensitive Data Exposure – Leakage of Cookie with Sensitive Data

Bài 8: Web App Hacking: Sensitive Data Exposure – Leakage of Sensitive Data via Referer Header

![[ASP.NET Core MVC] – Hướng dẫn tạo View p3](https://sinhvientot.net/wp-content/uploads/2019/01/Bitmap-MEDIUM_ASP.NET-Core-MVC-Logo_2colors_Square_Boxed_RGB-218x150.png)